Dance Diffusion 개요 안내

디퓨전 모델은 이미지 분야에서는 어디에나 있지만, 오디오 생성에서는 아직 본격적으로 자리 잡지 못했습니다. Harmonai 덕분에 그 흐름이 바뀌고 있습니다. 이 글은 AI 번역본입니다. 오역이 있을 수 있으니 댓글로 알려주세요.

Created on September 15|Last edited on September 15

Comment

Dance Diffusion이란 무엇인가?

Dance Diffusion은 오디오를 생성하는 머신러닝 모델 계열로, 다음에 의해 만들어졌습니다 Harmonai프로듀서와 뮤지션을 위해 오픈 소스 생성 오디오 도구를 개발하는 것을 사명으로 하는 커뮤니티 주도 조직이며, …의 일부입니다 Stability AI.

사전 학습된 Dance Diffusion 모델(또는 직접 학습한 Dance Diffusion 모델)을 사용하면 특정 스타일의 무작위 오디오 샘플을 생성하고, 주어진 오디오 샘플을 재생성하며, 두 개의 서로 다른 오디오 샘플 사이를 보간할 수 있습니다.

이름에서 알 수 있듯이, Dance Diffusion 모델은 확산 모델입니다.

확산 모델이란 무엇인가요?

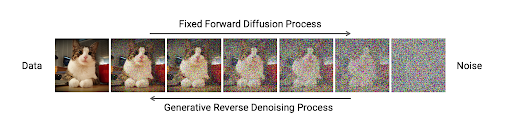

확산 모델은 학습한 데이터에 대해 데이터를 “파괴”하는 과정(“정방향 확산” 또는 “노이징”)과 다시 “복원”하는 과정(“역방향 확산” 또는 “디노이징”)을 학습함으로써 새로운 데이터를 생성하는 기계 학습 모델의 한 유형입니다.

학습 과정이 진행될수록, 모델은 앞서 파괴했던 데이터를 충실하게 복원하는 능력이 점점 향상됩니다.

이 기술 블로그 게시글 작성자 엔비디아 정방향과 역방향 과정을 보여줍니다. 모델은 어떤 데이터(예: 고양이 이미지)에 점진적으로 노이즈를 추가해 데이터가 순수한 노이즈가 될 때까지 진행한 다음, 다시 노이즈를 점진적으로 제거하여 이미지를 원래 형태로 복원합니다.

그렇다면 모델에게 무작위 노이즈를 복원해 달라고 요청하면 어떻게 될까요?

알고 보니, 학습된 확산 모델에 무작위 노이즈를 입력하면 역방향 확산 과정이 그 입력을 디노이징하여 모델이 학습해 복원할 수 있게 된 데이터와 동일한 유형의 것으로 바꿉니다. 다시 말해, 이것이 확산 모델이 새로운 데이터를 생성하는 방식입니다!

Dance Diffusion 모델은 오디오로 학습되었기 때문에 오디오를 생성하는 법을 익힙니다.

여기에서 Dance Diffusion 모델만으로 완전히 생성된 피아노 음악 샘플을 들어볼 수 있습니다.

Dance Diffusion은 무엇을 학습했나요?

현재 공개되어 있는 Dance Diffusion 모델은 6가지이며, 각각 서로 다른 오디오 파일 데이터셋으로 학습되었습니다:

확산 모델이 학습한 데이터, 즉 복원 방법을 배운 데이터가 이후 생성하는 데이터의 유형에 영향을 주기 때문에, 예를 들어 maestro-150k 모델로 만든 오디오 샘플은 항상 피아노 음악처럼 들리며 기타나 트럼펫 음악처럼 들리지 않습니다.

잭 에번스Dance Diffusion의 제작자인, 는 출시했습니다 Google Colab 노트북 용도를 위해 오픈 베타 접근 권한 위에 나열한 Dance Diffusion 모델에 대해. 에반스는 또한 사용자가 … 할 수 있도록 Colab 노트북을 작성했습니다 미세 조정또는 자체 데이터셋으로 Dance Diffusion 모델을 사용자 정의해 생성되는 오디오 클립을 보다 정밀하게 제어할 수 있습니다.

수정: 이 게시물은 삭제되었습니다! 직접 Dance Diffusion 모델을 사용해 보거나 미세 조정해 보고 싶다면, Reddit 사용자님의 게시물을 확인해 보세요 u/Stapler_Enthusiast 자세한 Dance Diffusion 튜토리얼.

마지막으로, Harmonai가 공개한 모델 중 하나로 직접 음악 샘플을 만들어 보고 싶다면, 아래에 Colab 링크를 준비해 두었습니다!

Add a comment

The tutorial link near the bottom of this article goes to a reddit post which has been deleted :/

1 reply