学生、教育者、学術研究者には常に無料で提供されています。

W&B は、あらゆる分野の学者が研究に協力し、モデルを再現し、最新の洞察を共有し、より良いモデルをより迅速に構築できるように支援します。

一流の大学、一流の研究者、50万人を超えるML実践者から信頼されています

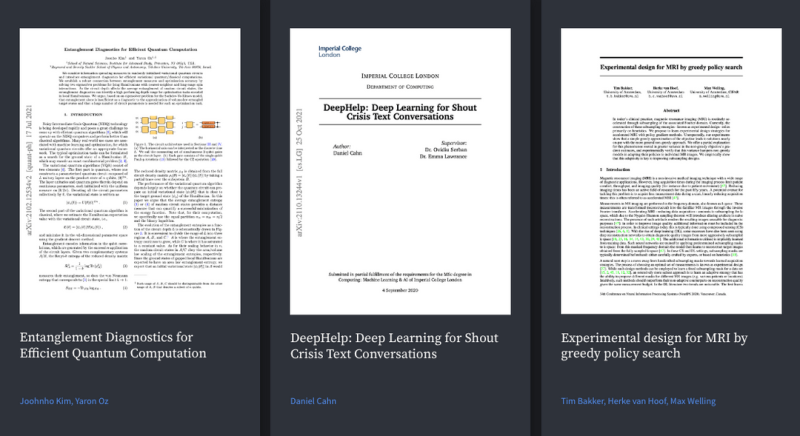

最先端の研究者たちによって信頼され、引用されているWeights & Biases

気候科学から医療研究、NLPやコンピュータビジョンの基本的なブレークスルーに至るまで、Weights & Biasesは研究をより再現可能で協力的にするために裏方でサポートしています。W&Bを引用した500以上の論文の一部をご覧ください。

教育者、ティーチングアシスタント、そして学生向けのリソース

イントロダクションコンテンツを用意しました。これにより、あなたとあなたの学生がWeights & Biasesを活用して、授業、研究、または学生運営の組織で協力的かつ再現可能な機械学習や深層学習を始める手助けができます。

研究と教育のためのW&B

再現可能な研究のための自動ロギング

DALL-E miniとの共同研究入門

W&B レポートでの調査結果の共有

W&B を使用して出版用グラフィックを作成する方法

教室の課題としての W&B レポートの例

Weights & Biasesの引用方法

W&Bを使用して研究が成功した場合は、ぜひお知らせください。右側の情報で私たちを引用することもできますが、何よりもあなたの仕事についてお聞きしたいです。research@wandb.comまでメールをお送りください。ご連絡お待ちしております。

@misc{wandb,

title = {Experiment Tracking with Weights and Biases},

year = {2020},

note = {Software available from wandb.com},

url={https://www.wandb.com/},

author = {Biewald, Lukas},

}

title = {Experiment Tracking with Weights and Biases},

year = {2020},

note = {Software available from wandb.com},

url={https://www.wandb.com/},

author = {Biewald, Lukas},

}

すべてをログに記録して、何も失わないようにしましょう

再現できない実験は、次の大きな発見には役立ちません。 Weights & Biases を使用すると、何を記録するか、いつ記録するかを選択できるため、手動管理を減らし、より多くのモデル トレーニングを行うことができます。

すべての人気フレームワークや数千のMLリポジトリと統合されています

Weights & Biasesは他のツールともうまく連携します。PyTorch、Keras、JAXから、MLのさまざまなリポジトリに至るまで、私たちが統合されている可能性が高いです。最も人気のある統合とその動作方法については、ドキュメントで確認してください。

あなたの大学で W&B イベントを主催してみませんか?左側のボタンをクリックしてください。ご連絡させていただきます。

専門家から学びましょう

MLOps、CI/CD、LLMs、またはWeights & Biasesの使い方について学びたいですか?無料のコースで始めることができます!すべてのコースは以下でご覧いただけます。

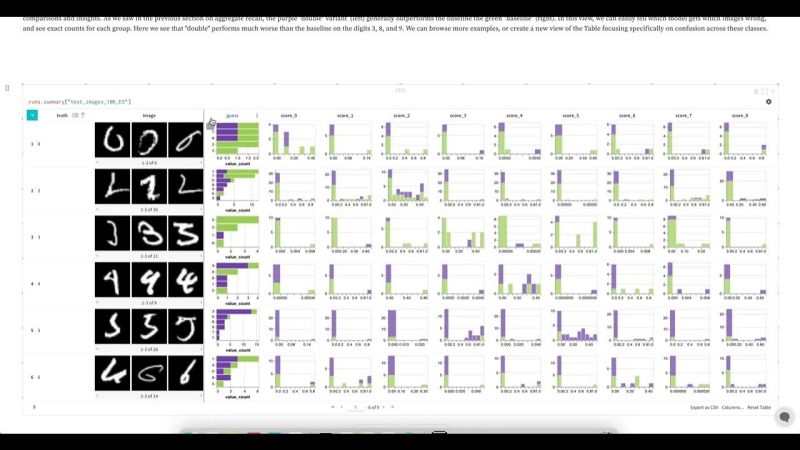

リアルタイムでチームとコラボレーションしましょう

Weights & Biases はコラボレーションのために作られています。すべての実験が 1 つのシステムに記録されるため、研究チームはすべてのデータセットとモデルのバージョン、git コミット、および最近の実験へのアクセスを共有します。

Weights & Biases プラットフォームは、

ワークフローをEnd-to-Endで効率化します

W&B Models

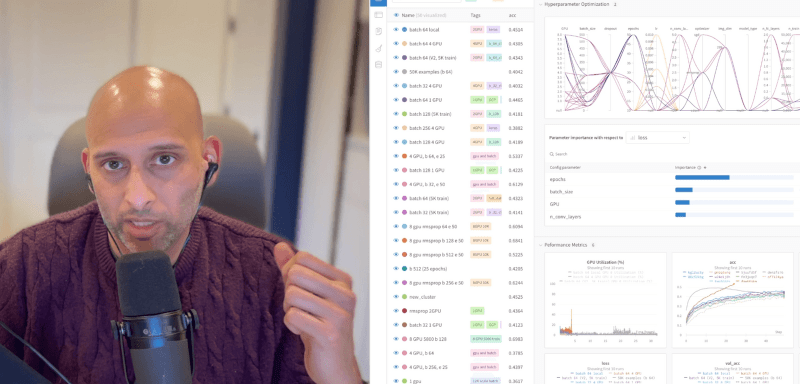

Experiments

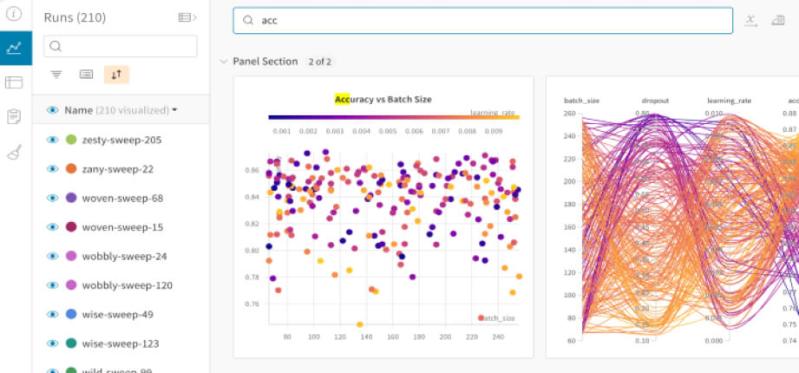

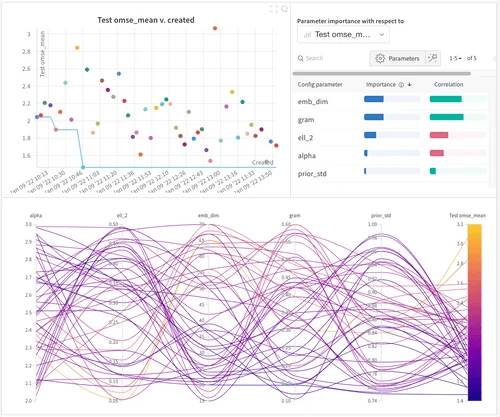

ML実験のトラッキング

と可視化

Sweeps

ハイパーパラメータの

最適化

Registry

モデルとデータセット

の共有と公開

Automations

ワークフローの

自動トリガー

Launch

MLワークフローを

パッケージ化して実行

W&B Weave

Traces

LLMとプロンプトの

記録とトラッキング

Evaluations

生成AIアプリケーション

の評価

ML モデルを追跡、比較、視覚化する 5行のコードで

スクリプトに数行を追加するだけで実験ログを迅速かつ簡単に実装し、結果のログを開始します。私たちの軽量な統合は、あらゆる Python スクリプトで動作します。

# Flexible integration for any Python script

import wandb

# 1. Start a W&B run

wandb.init(project='gpt3')

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

# Model training here

# 3. Log metrics over time to visualize performance

wandb.log({"loss": loss})

import wandb

# 1. Start a W&B run

wandb.init(project='gpt3')

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

# Model training here

# 3. Log metrics over time to visualize performance

with tf.Session() as sess:

# ...

wandb.tensorflow.log(tf.summary.merge_all())

import wandb

# 1. Start a new run

wandb.init(project="gpt-3")

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

# 3. Log gradients and model parameters

wandb.watch(model)

for batch_idx, (data, target) in

enumerate(train_loader):

if batch_idx % args.log_interval == 0:

# 4. Log metrics to visualize performance

wandb.log({"loss": loss})

import wandb

from wandb.keras import WandbCallback

# 1. Start a new run

wandb.init(project="gpt-3")

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

... Define a model

# 3. Log layer dimensions and metrics over time

model.fit(X_train, y_train, validation_data=(X_test, y_test),

callbacks=[WandbCallback()])

import wandb

wandb.init(project="visualize-sklearn")

# Model training here

# Log classifier visualizations

wandb.sklearn.plot_classifier(clf, X_train, X_test, y_train,

y_test, y_pred, y_probas, labels, model_name='SVC',

feature_names=None)

# Log regression visualizations

wandb.sklearn.plot_regressor(reg, X_train,

X_test, y_train, y_test, model_name='Ridge')

# Log clustering visualizations

wandb.sklearn.plot_clusterer(kmeans, X_train, cluster_labels, labels=None, model_name='KMeans')

# 1. Import wandb and login

import wandb

wandb.login()

# 2. Define which wandb project to log to and name your run

wandb.init(project="gpt-3", run_name='gpt-3-base-high-lr')

# 3. Add wandb in your Hugging Face `TrainingArguments`

args = TrainingArguments(... , report_to='wandb')

# 4. W&B logging will begin automatically when your start training your Trainer

trainer = Trainer(... , args=args)

trainer.train()

import wandb

# 1. Start a new run

wandb.init(project="visualize-models",

name="xgboost")

# 2. Add the callback

bst = xgboost.train(param, xg_train, num_round,

watchlist, callbacks=

[wandb.xgboost.wandb_callback()])

# Get predictions

pred = bst.predict(xg_test)