Evaluationsを使用して、自信を持ってGenAIアプリケーションを改善

LLM を使用して構築する開発者は、実稼働環境で常に反復して堅牢なパフォーマンスを実現するために、モデルのパフォーマンスを継続的に評価する必要があります。

評価を使用すると、アプリケーションのパフォーマンス指標を簡単に整理して比較できます。さまざまなシナリオにわたってモデルの精度を測定および検証します。体系的な評価で厳密さを構築し、非決定的な生成AI アプリケーションのさまざまな側面をスコアリングし、自信を持って導入します。

生成AIアプリケーションを軽量かつカスタマイズ可能な方法で評価

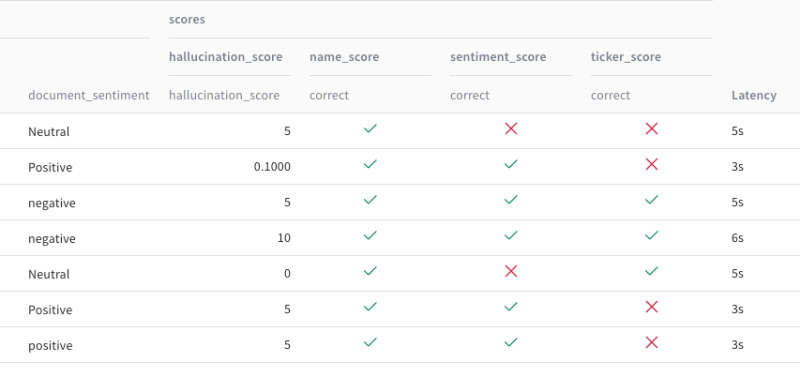

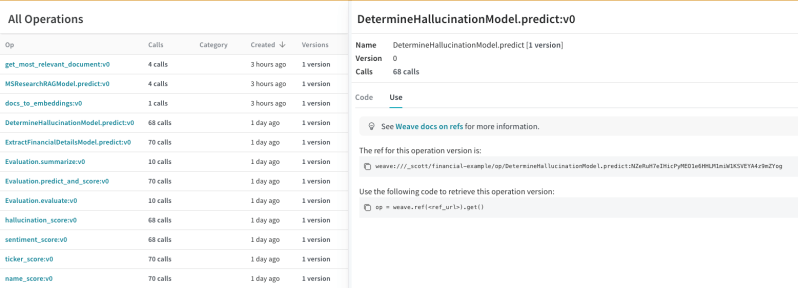

開発者のエクスペリエンスを念頭に置いて構築された評価機能により、LLM パフォーマンスのログ記録と比較が簡単に行えます。スコアラーを使用するか、独自の評価スコアを定義して、アプリケーションのパフォーマンスのさまざまな側面を評価するユースケースに必要な複雑または単純な関数を作成します。

「感覚的な確認」を超えて

自動評価を構築して、確実に反復できるようにします。難しい例を掘り下げて、各中間入力にどのようなデータが使用されているかを確認し、問題がどこにあるかを正確に根本原因を特定します。

体系的かつ組織化された評価フレームワークで厳密性を構築

すべての重要な要素を 1 つの統合された場所で追跡および管理することで、生成AI アプリケーションの導入に必要な自信をチームに与えます。評価をスケールアップして、最新のモデル、プロンプト、テクニックを自信を持って実験できるようにします。

Weights & Biases プラットフォームは、

ワークフローをEnd-to-Endで効率化します

W&B Models

Experiments

ML実験のトラッキング

と可視化

Sweeps

ハイパーパラメータの

最適化

Registry

モデルとデータセット

の共有と公開

Automations

ワークフローの

自動トリガー

Launch

MLワークフローを

パッケージ化して実行

W&B Weave

Traces

LLMとプロンプトの

記録とトラッキング

Evaluations

生成AIアプリケーション

の評価