Models

Train, fine-tune, and manage AI models

W&B 모델은 실험에서 생산에 이르기까지 모델을 훈련, 파인 튜닝, 관리, 통제하여 시장 출시 시간을 단축할 수 있도록 지원합니다. 실험 속도와 팀 협업을 향상시켜 성능, 데이터 안정성 및 보안을 보장하면서 모델을 더 빠르게 프로덕션에 도입할 수 있습니다. 더 많은 실험을 실행하고, 대화형으로 분석하고, 고품질 모델을 빠르게 구축하세요. 레지스트리에서 모델, 데이터 세트, 메타데이터 및 그 계보를 중앙 집중식으로 추적하여 거버넌스, 재현성 및 CI/CD를 지원하세요. 교육, 평가 및 배포를 위한 워크플로를 자동화하여 신속한 반복을 지원합니다.

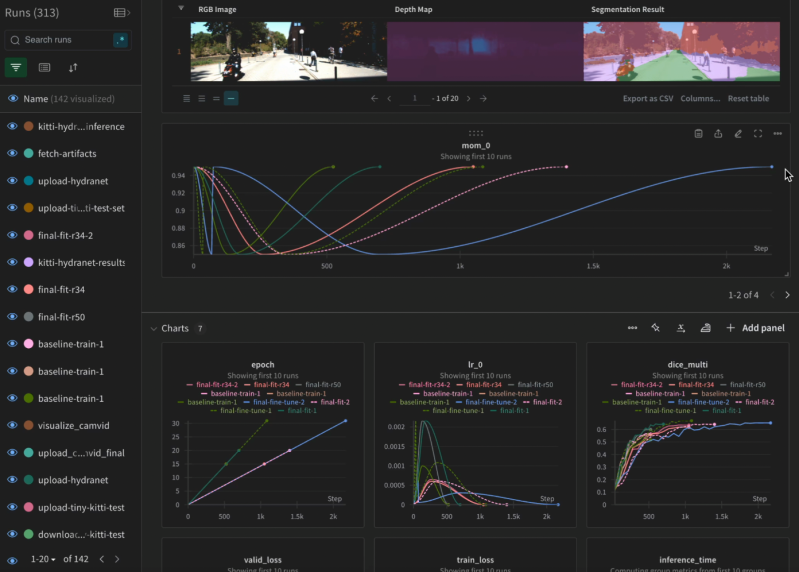

Accelerate experiment velocity

몇 줄의 코드만으로 실험을 추적, 버전 관리 및 시각화할 수 있습니다. 수십만 개의 실험을 더 빠르게 실행하고 더 높은 품질의 모델을 더 빠르게 생성하세요. 실험 결과를 쉽게 시각화 및 분석하고 인사이트를 발견하세요.

Manage models centrally

학습 후에는 레지스트리에 모델, 데이터 세트 및 메타데이터를 게시하고 공유하여 모든 AI 자산에 대한 단일 소스를 만들 수 있습니다. 이를 통해 재현성, 버전 관리, 계보 추적, 지속적인 통합/배포(CI/CD)가 가능합니다.

Infinite scale, responsive UI

100K+

Visualize experiments interactively at any scale, no limit on visible runs

1000’s

of metrics with correlations

Full fidelity

charts with every data spike visible on the graph

Hyperscale data ingestion

1M+

data points per second ingestion speed

Redundancy

controls to prevent data loss

Built-in

support for distributed training

Long-running experiments

Run forking

for monitoring months-long experiments

Replay

mechanism if part of ingestion fails due to system or network issues

Asynchronous

streaming data ingestion

Scale with performance

W&B 모델은 대규모의 장기적인 실험과 광범위한 데이터 로깅을 지원하도록 설계되었습니다. 빠른 로깅 성능으로 수천 개의 메트릭과 수백만 개의 데이터 포인트로 10만 개 이상의 실험을 실행하세요. 프론티어 AI 규모로 대용량 모델 파일을 빠르게 업로드하고 다운로드하세요.

Improve governance and security

Registry와 Lineage 그래프를 사용하여 주어진 모델에 대한 정확한 레시피를 재현하여 협업과 규정 준수를 개선하세요. W&B 모델은 엔드포인트 보호, 암호화, 백업 제어를 통해 엔터프라이즈 보안을 제공합니다. 사용자 지정 역할, 팀, 프로젝트를 통해 세분화된 역할 기반 액세스를 제공하므로 적절한 액세스 수준으로 데이터를 안전하게 공유할 수 있습니다. 강력한 암호화로 데이터를 보호합니다: 전송 중일 때는 TLS 1.2+를, 미사용 시에는 AES 256을 사용해 데이터 수명 주기 내내 보안을 보장합니다.

Extensive system metrics tracking

W&B 모델은 NVIDIA와 같은 하드웨어 플랫폼과 사전 구축된 통합 기능을 제공하여 모든 범위의 GPU/CPU 시스템 메트릭을 즉시 추적합니다. W&B 모델을 사용하면 이 데이터를 다른 지표와 나란히 시각화하여 GPU 활용도를 극대화하고 훈련 비용을 절감할 수 있습니다. 시스템 메트릭 로깅을 직접 설정해야 하는 번거로움이 없습니다. 추적할 수 있는 항목 알아보기

Built-in integrations

공급업체나 프레임워크에 종속되지 않고 기존 ML 개발 스택과 쉽게 integration이 가능합니다. 가장 일반적으로 사용되는 ML 프레임워크, 라이브러리 및 리포지토리에 대한 수천 개의 intergrations 기능을 갖춘 W&B SDK는 팀에서 매일 사용하는 도구와 함께 작동합니다. integrations 기능 보기

import wandb

# 1. Start a W&B run

run = wandb.init(project="my_first_project")

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

# 3. Log metrics to visualize performance over time

for i in range(10):

run.log({"loss": 2**-i})

import weave

from langchain_core.prompts import PromptTemplate

from langchain_openai import ChatOpenAI

# Initialize Weave with your project name

weave.init("langchain_demo")

llm = ChatOpenAI()

prompt = PromptTemplate.from_template("1 + {number} = ")

llm_chain = prompt | llm

output = llm_chain.invoke({"number": 2})

print(output)

import weave

from llama_index.core.chat_engine import SimpleChatEngine

# Initialize Weave with your project name

weave.init("llamaindex_demo")

chat_engine = SimpleChatEngine.from_defaults()

response = chat_engine.chat(

"Say something profound and romantic about fourth of July"

)

print(response)

import wandb

# 1. Start a new run

run = wandb.init(project="gpt5")

# 2. Save model inputs and hyperparameters

config = run.config

config.dropout = 0.01

# 3. Log gradients and model parameters

run.watch(model)

for batch_idx, (data, target) in enumerate(train_loader):

...

if batch_idx % args.log_interval == 0:

# 4. Log metrics to visualize performance

run.log({"loss": loss})

import wandb

# 1. Define which wandb project to log to and name your run

run = wandb.init(project="gpt-5",

run_name="gpt-5-base-high-lr")

# 2. Add wandb in your `TrainingArguments`

args = TrainingArguments(..., report_to="wandb")

# 3. W&B logging will begin automatically when your start training your Trainer

trainer = Trainer(..., args=args)

trainer.train()

from lightning.pytorch.loggers import WandbLogger

# initialise the logger

wandb_logger = WandbLogger(project="llama-4-fine-tune")

# add configs such as batch size etc to the wandb config

wandb_logger.experiment.config["batch_size"] = batch_size

# pass wandb_logger to the Trainer

trainer = Trainer(..., logger=wandb_logger)

# train the model

trainer.fit(...)

import wandb

# 1. Start a new run

run = wandb.init(project="gpt4")

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

# Model training here

# 3. Log metrics to visualize performance over time

with tf.Session() as sess:

# ...

wandb.tensorflow.log(tf.summary.merge_all())

import wandb

from wandb.keras import (

WandbMetricsLogger,

WandbModelCheckpoint,

)

# 1. Start a new run

run = wandb.init(project="gpt-4")

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

... # Define a model

# 3. Log layer dimensions and metrics

wandb_callbacks = [

WandbMetricsLogger(log_freq=5),

WandbModelCheckpoint("models"),

]

model.fit(

X_train, y_train, validation_data=(X_test, y_test),

callbacks=wandb_callbacks,

)

import wandb

wandb.init(project="visualize-sklearn")

# Model training here

# Log classifier visualizations

wandb.sklearn.plot_classifier(clf, X_train, X_test, y_train, y_test, y_pred, y_probas, labels,

model_name="SVC", feature_names=None)

# Log regression visualizations

wandb.sklearn.plot_regressor(reg, X_train, X_test, y_train, y_test, model_name="Ridge")

# Log clustering visualizations

wandb.sklearn.plot_clusterer(kmeans, X_train, cluster_labels, labels=None, model_name="KMeans")

import wandb

from wandb.xgboost import wandb_callback

# 1. Start a new run

run = wandb.init(project="visualize-models")

# 2. Add the callback

bst = xgboost.train(param, xg_train, num_round, watchlist, callbacks=[wandb_callback()])

# Get predictions

pred = bst.predict(xg_test)

Secure deployment for enterprises

Saas cloud

Dedicated cloud

Flexibility of deployment options

W&B 모델에서는 당사가 관리하는 멀티테넌트 및 전용 클라우드 환경과 고객이 독립적으로 관리하는 온프레미스 및 프라이빗 클라우드 환경 등 다양한 배포 옵션을 선택할 수 있습니다.