The era of generative AI

세계 최고의 AI 팀이 Weights & Biases를 신뢰하고 있습니다

빠르게 통합하고, 추적 및 버전 관리를 자동화하세요

- 단 5줄의 코드로 추적, 버전 관리 및 시각화

- 모든 모델 체크포인트 재현

- CPU 및 GPU 사용량 실시간 모니터링

“우리는 이전보다 50~100배 더 많은 ML 실험을 진행하고 있습니다.”

import wandb

# 1. Start a W&B run

run = wandb.init(project="my_first_project")

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

# 3. Log metrics to visualize performance over time

for i in range(10):

run.log({"loss": loss})

import wandb

import os

# 1. Set environment variables for the W&B project and tracing.

os.environ["LANGCHAIN_WANDB_TRACING"] = "true" os.environ["WANDB_PROJECT"] = "langchain-tracing"

# 2. Load llms, tools, and agents/chains

llm = OpenAI(temperature=0)

tools = load_tools(["llm-math"], llm=llm)

agent = initialize_agent(

tools, llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

# 3. Serve the chain/agent with all underlying complex llm interactions automatically traced and tracked

agent.run("What is 2 raised to .123243 power?")

import wandb

from llama_index import ServiceContext

from llama_index.callbacks import CallbackManager, WandbCallbackHandler

# initialise WandbCallbackHandler and pass any wandb.init args

wandb_args = {"project":"llamaindex"}

wandb_callback = WandbCallbackHandler(run_args=wandb_args)

# pass wandb_callback to the service context

callback_manager = CallbackManager([wandb_callback])

service_context = ServiceContext.from_defaults(callback_manager=

callback_manager)

import wandb

# 1. Start a new run

run = wandb.init(project="gpt5")

# 2. Save model inputs and hyperparameters

config = run.config

config.dropout = 0.01

# 3. Log gradients and model parameters

run.watch(model)

for batch_idx, (data, target) in enumerate(train_loader):

...

if batch_idx % args.log_interval == 0:

# 4. Log metrics to visualize performance

run.log({"loss": loss})

import wandb

# 1. Define which wandb project to log to and name your run

run = wandb.init(project="gpt-5",

run_name="gpt-5-base-high-lr")

# 2. Add wandb in your `TrainingArguments`

args = TrainingArguments(..., report_to="wandb")

# 3. W&B logging will begin automatically when your start training your Trainer

trainer = Trainer(..., args=args)

trainer.train()

from lightning.pytorch.loggers import WandbLogger

# initialise the logger

wandb_logger = WandbLogger(project="llama-4-fine-tune")

# add configs such as batch size etc to the wandb config

wandb_logger.experiment.config["batch_size"] = batch_size

# pass wandb_logger to the Trainer

trainer = Trainer(..., logger=wandb_logger)

# train the model

trainer.fit(...)

import wandb

# 1. Start a new run

run = wandb.init(project="gpt4")

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

# Model training here

# 3. Log metrics to visualize performance over time

with tf.Session() as sess:

# ...

wandb.tensorflow.log(tf.summary.merge_all())

import wandb

from wandb.keras import (

WandbMetricsLogger,

WandbModelCheckpoint,

)

# 1. Start a new run

run = wandb.init(project="gpt-4")

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

... # Define a model

# 3. Log layer dimensions and metrics

wandb_callbacks = [

WandbMetricsLogger(log_freq=5),

WandbModelCheckpoint("models"),

]

model.fit(

X_train, y_train, validation_data=(X_test, y_test),

callbacks=wandb_callbacks,

)

import wandb

wandb.init(project="visualize-sklearn")

# Model training here

# Log classifier visualizations

wandb.sklearn.plot_classifier(clf, X_train, X_test, y_train, y_test, y_pred, y_probas, labels,

model_name="SVC", feature_names=None)

# Log regression visualizations

wandb.sklearn.plot_regressor(reg, X_train, X_test, y_train, y_test, model_name="Ridge")

# Log clustering visualizations

wandb.sklearn.plot_clusterer(kmeans, X_train, cluster_labels, labels=None, model_name="KMeans")

import wandb

from wandb.xgboost import wandb_callback

# 1. Start a new run

run = wandb.init(project="visualize-models")

# 2. Add the callback

bst = xgboost.train(param, xg_train, num_round, watchlist, callbacks=[wandb_callback()])

# Get predictions

pred = bst.predict(xg_test)

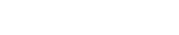

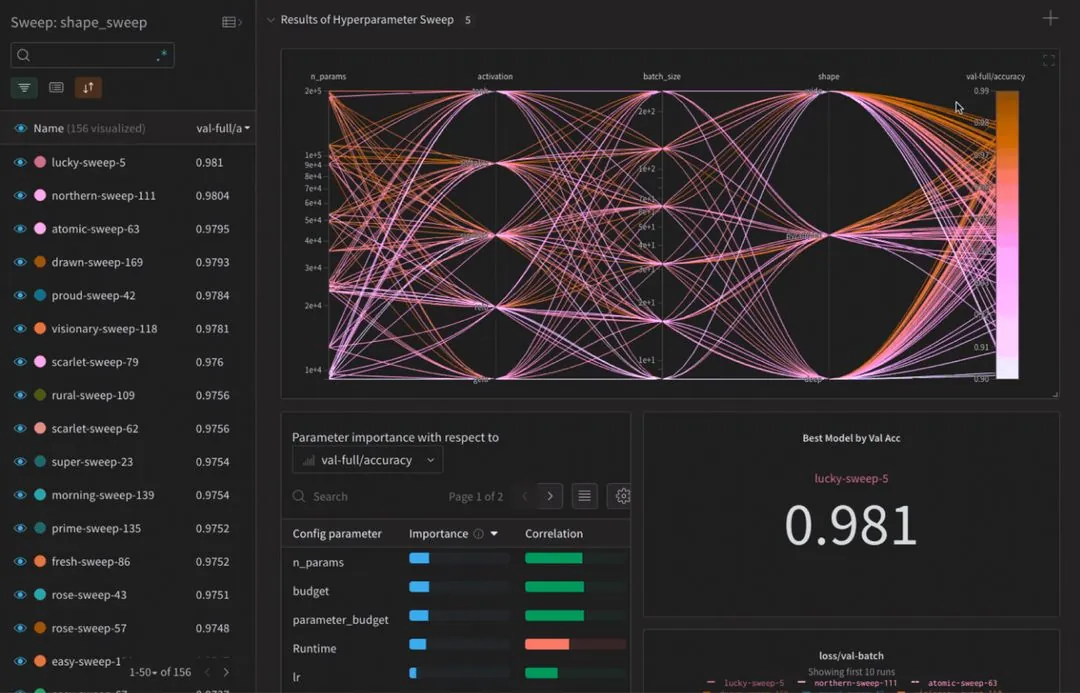

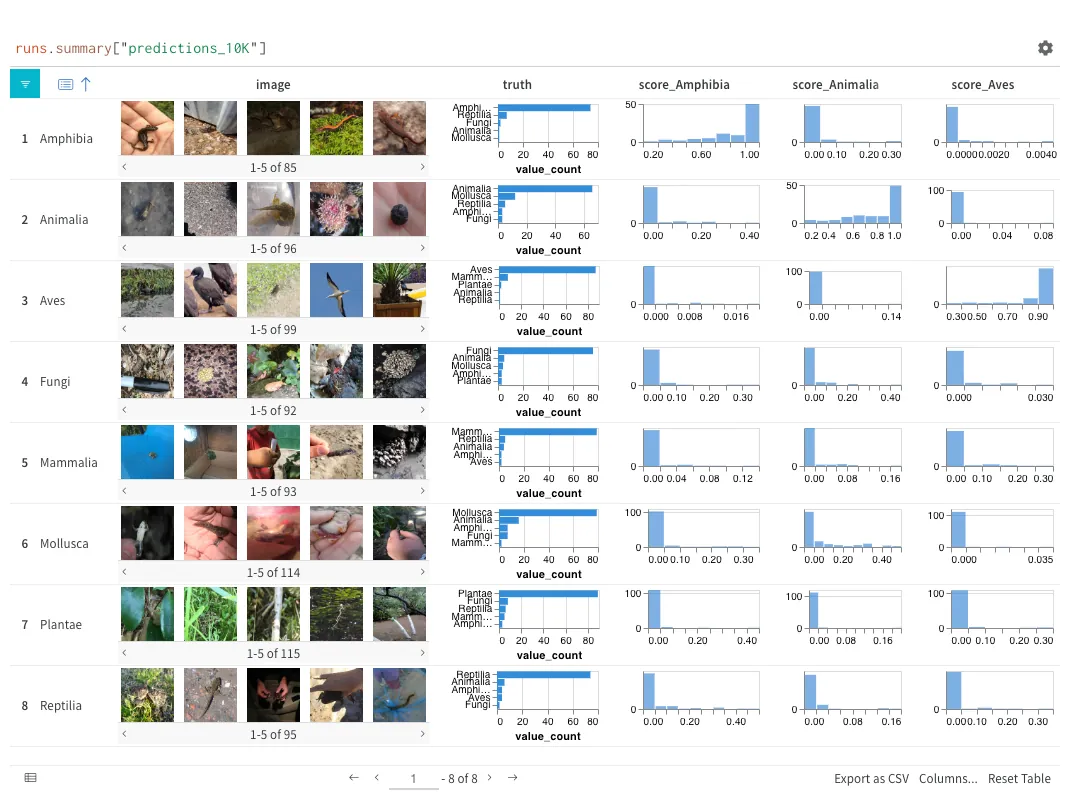

데이터를 시각화하고 중요한 통찰력을 발견하세요

- 중앙 위치에서 실시간 지표, 데이터 세트, 로그, 코드 및 시스템 통계를 시각화합니다.

- 팀 전체가 공동으로 분석하여 핵심 통찰력을 찾아냅니다.

- 나란히 비교하여 쉽게 디버깅하고 반복적으로 빌드

“모델 파이프라인의 모든 내용을 저장하는 것은 디버깅, 출처, 재현성 등 진지한 머신러닝에 필수적입니다. W&B는 이 작업을 수행하는 데 훌륭한 도구입니다.”

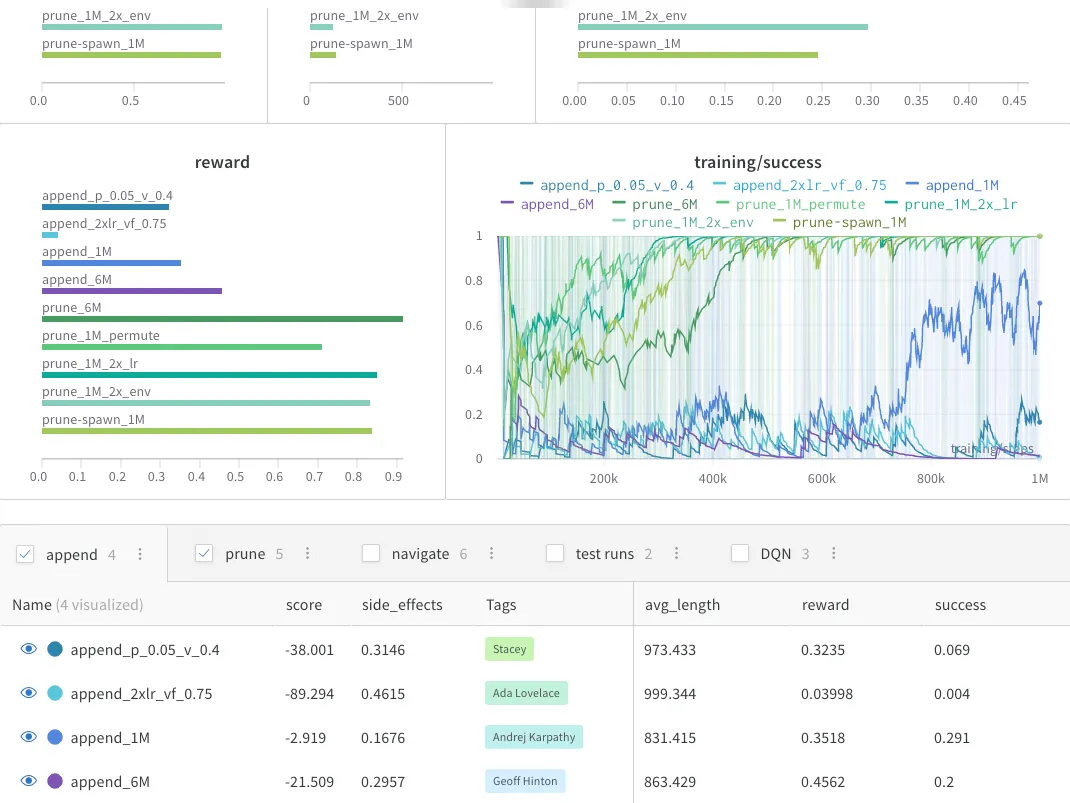

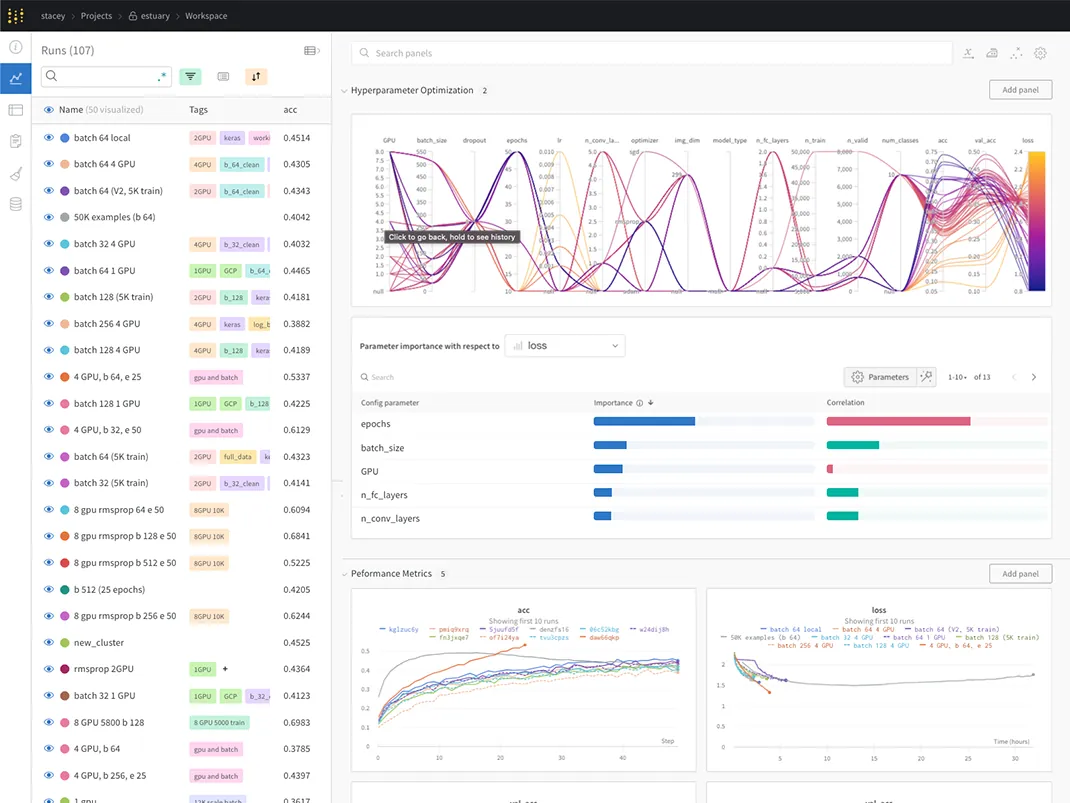

성능을 향상하여 다음을 수행할 수 있습니다. 자신있게 평가하고 배포하세요

- 최고의 모델을 찾기 위해 공동으로 실험해 보세요.

- 모델을 평가하고, 버그에 대해 논의하고, 진행 상황을 보여줍니다.

- 구성 가능한 보고서로 이해관계자에게 정보 제공

W&B를 사용하면 한 명의 연구원에서 전체 팀으로, 단일 컴퓨터에서 수천 대까지 통찰력을 확장할 수 있습니다.

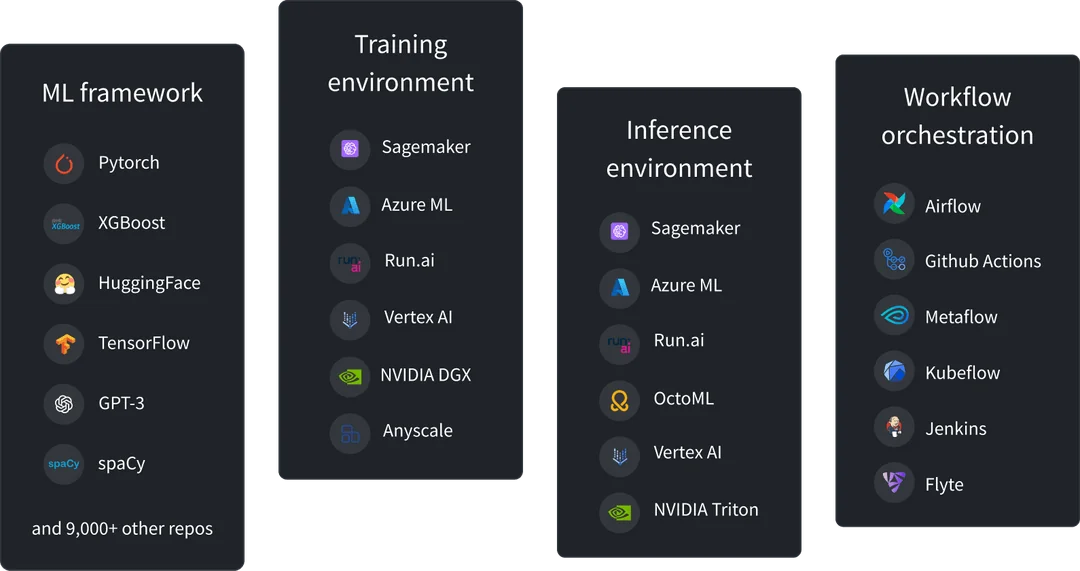

The Weights & Biases ecosystem

A unified interface over any ML infrastructure

- Pytorch

- XGBoost

- HuggingFace

- TensorFlow

- OpenAI Models

- OpenCV

- Sagemaker

- Azure ML

- Run.ai

- Vertex AI

- NVIDIA DGX

- Anyscale

- Airflow

- Github Actions

- Metaflow

- Kubeflow

- Jenkins

- Flyte

- Astronomer

- Sagemaker

- Azure ML

- Run.ai

- Vertex AI

- NVIDIA DGX

- OctoML

제공하는 선도적인 AI 개발자 플랫폼 팀 전체에 대한 가치

중복되는 사용자 경험 일이 사라지다

ML 파이프라인의 모든 세부정보를 자동으로 추적합니다. 관련 컨텍스트를 통해 결과를 시각화합니다. 드래그 & 통찰력을 발견하기 위한 드롭 분석 – 단 몇 번의 클릭만으로 차선책 모델을 얻을 수 있습니다

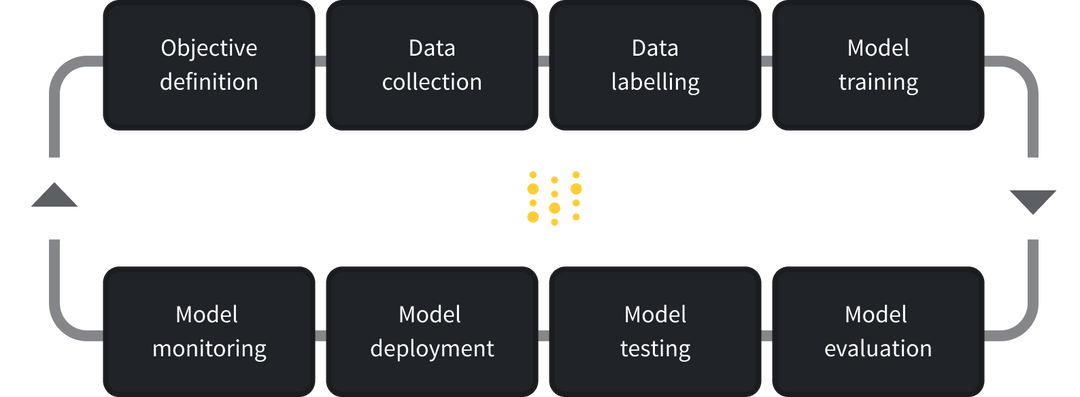

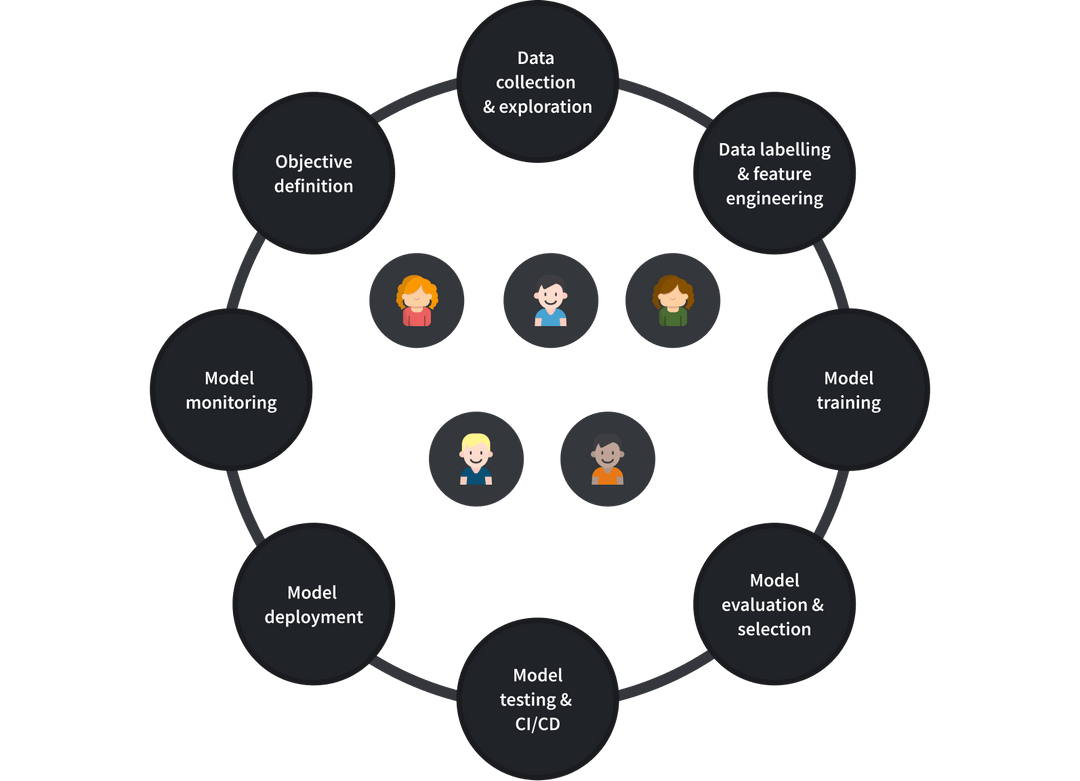

ML 워크플로 co-designed with ML engineers

간소화된 ML 워크플로를 점진적으로 구축하세요. 모든 단계를 구성하고 맞춤화하세요. 지능적인 기본값을 활용하면 바퀴를 다시 만들 필요가 없습니다.

기록을 남기는 시스템 모든 기록은 재현 가능하고 검색 가능합니다.

모든 실험을 즉시 재현하세요. 그 과정에서 설명되는 변경 사항을 통해 모델 발전을 추적하세요. 팀 작업을 쉽게 발견하고 이를 기반으로 구축하세요.

유연한 배포, 쉬운 통합

W&B를 원하는 인프라에 배포하세요. W&B 관리 또는 자체 관리가 가능합니다. ML 스택과 쉽게 통합 & 공급업체에 종속되지 않는 도구입니다.

브리지 ML 실무자 및 MLOps

단일 협업 인터페이스에서 ML 워크로드를 자동화하고 확장하세요. ML 실무자는 단순성을 얻고 MLOps는 가시성을 얻습니다.

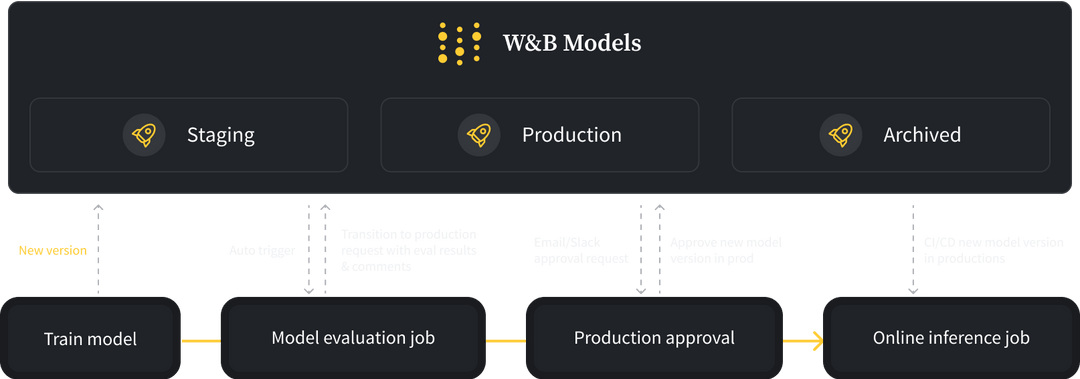

ML 프로덕션 확장 거버넌스와 함께

모든 ML 프로젝트를 위한 중앙 집중식 기록 시스템입니다. 모델 수명주기 및 CI/CD를 관리하여 생산을 가속화합니다. 모델 진화를 이해하고 비즈니스가 리더십에 미치는 영향을 설명합니다.

중복되는 사용자 경험 일이 사라지다

ML 파이프라인의 모든 세부정보를 자동으로 추적합니다. 관련 컨텍스트를 통해 결과를 시각화합니다. 드래그 & 통찰력을 발견하기 위한 드롭 분석 – 단 몇 번의 클릭만으로 차선책 모델을 얻을 수 있습니다

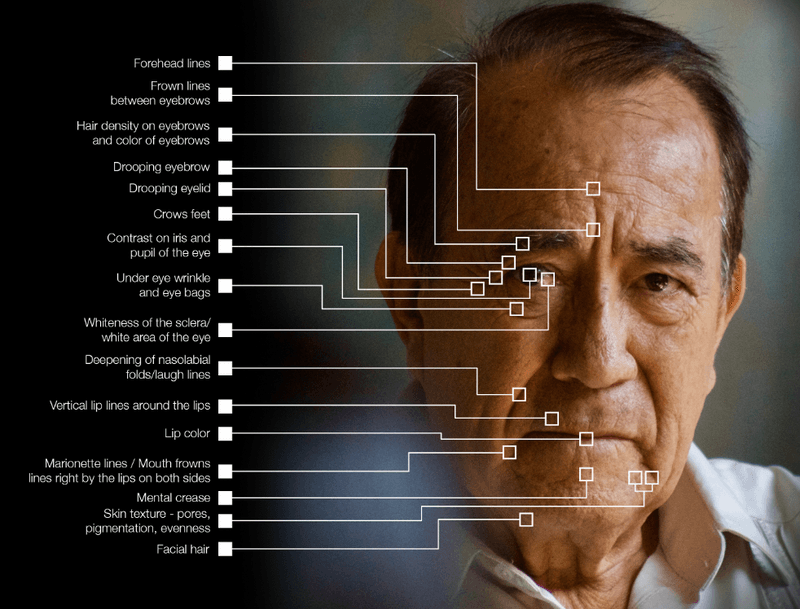

어떤 업종이든, 모든 사용 사례

다양한 업계의 고객은 다양한 ML 사용 사례를 갖춘 W&B를 신뢰합니다. 자율 주행 차량부터 신약 개발까지, 고객 지원 자동화부터 생성 AI까지 W&B의 유연한 워크플로우는 모든 맞춤형 요구사항을 처리합니다.

팀이 집중하게 해주세요 value-added activities

핵심 ML 활동에만 집중 – W&B는 지루한 작업을 자동으로 처리합니다. 재현성 , 감사 가능성, 인프라 관리, 보안 및amp; 거버넌스.

미래에 대비한 ML 워크플로 – W&B는 OpenAI 및 기타 혁신자들과 공동 설계하여 비법 소스를 인코딩하므로 바퀴를 다시 만들 필요가 없습니다.

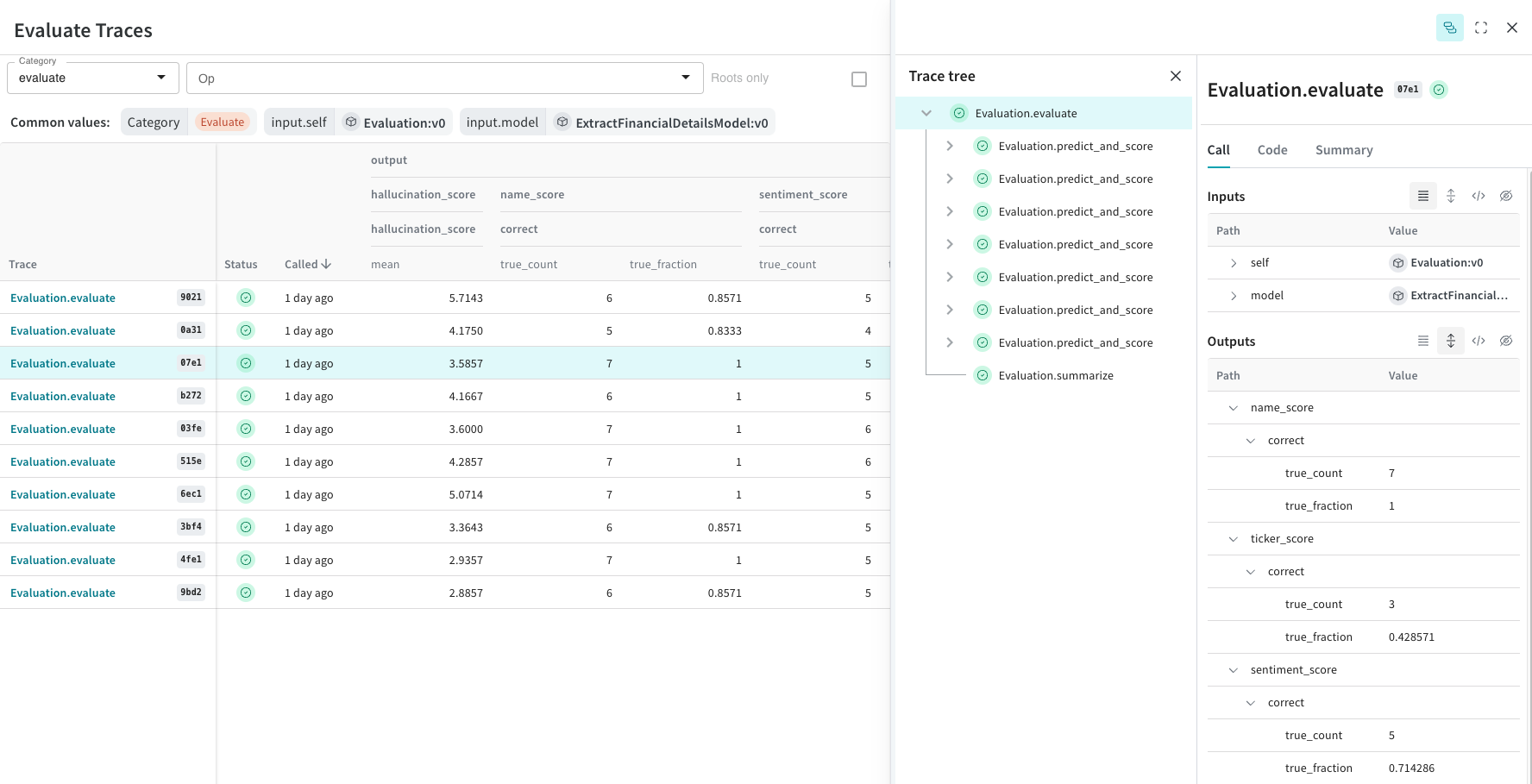

소프트웨어 개발자가 GenAI 애플리케이션을 자신있게 배포할 수 있도록 설계되었습니다.

개발자가 동적이고 비결정적인 대규모 언어 모델을 평가, 이해 및 반복하는 데 필요한 도구입니다.

간단한 디버깅을 위해 모든 입력, 출력 및 추적을 자동으로 기록합니다.

Weave는 모든 입력 및 출력 데이터를 캡처하고 트리를 구축하여 개발자가 애플리케이션을 통해 데이터가 어떻게 흐르는지 완벽하게 관찰하고 이해할 수 있도록 합니다.

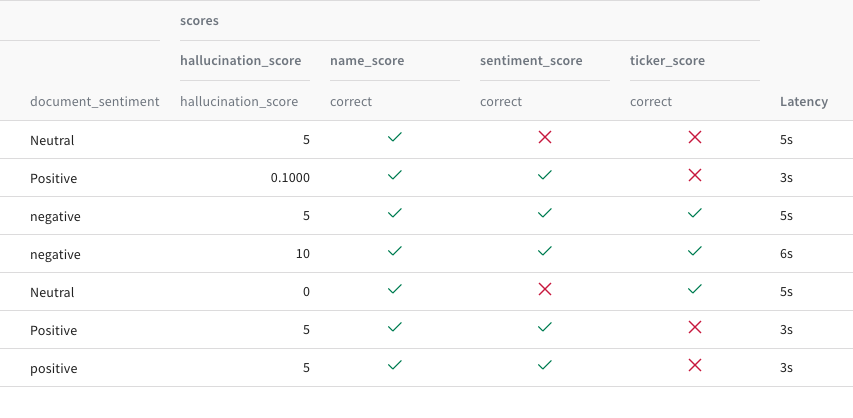

강력한 LLM 성과를 제공하는 엄격한 평가 프레임워크

다양한 성능 차원과 모델 결과에 대한 다양한 평가를 비교하여 프로덕션에 배포할 때 애플리케이션이 최대한 강력한지 확인하세요.

30개 이상의 기초 모델 구축업체와 1,000개 이상의 기업이 신뢰함

"W&B was fundamental for launching our internal machine learning systems, as it enables collaboration across various teams."

"W&B is a key piece of our fast-paced, cutting-edge, large-scale research workflow: great flexibility, performance, and user experience."

"W&B allows us to scale up insights from a single researcher to the entire team and from a single machine to thousands."